GoogleはNotebookLMについて、日本語なども含む200以上の地域での対応を発表しました。

外部データをユーザーが与えて、それに関する質問をAIが答えてくれるサービスのようです。

以下のリンクからGoogleアカウントさえあれば、無料(2024/06/07時点)で使えます

実際に使ってみましょう。

仕様

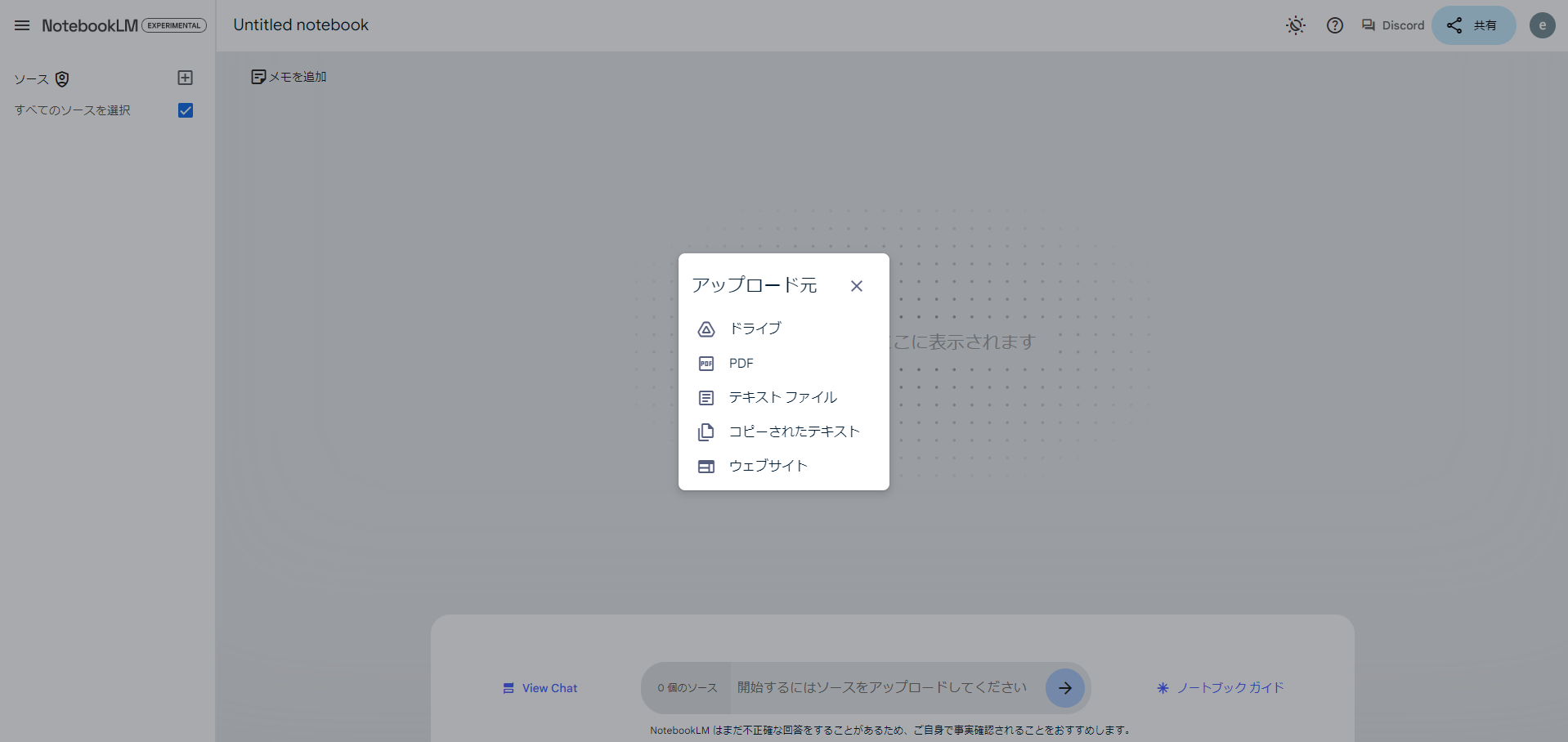

新しいノートブックを開くと、アップロードする外部データの形式を聞かれます

現在は、googleドライブ、pdf、テキストファイル、文字データ(コピペ)、ウェブサイトから選べるようです。

英論を与えてみる

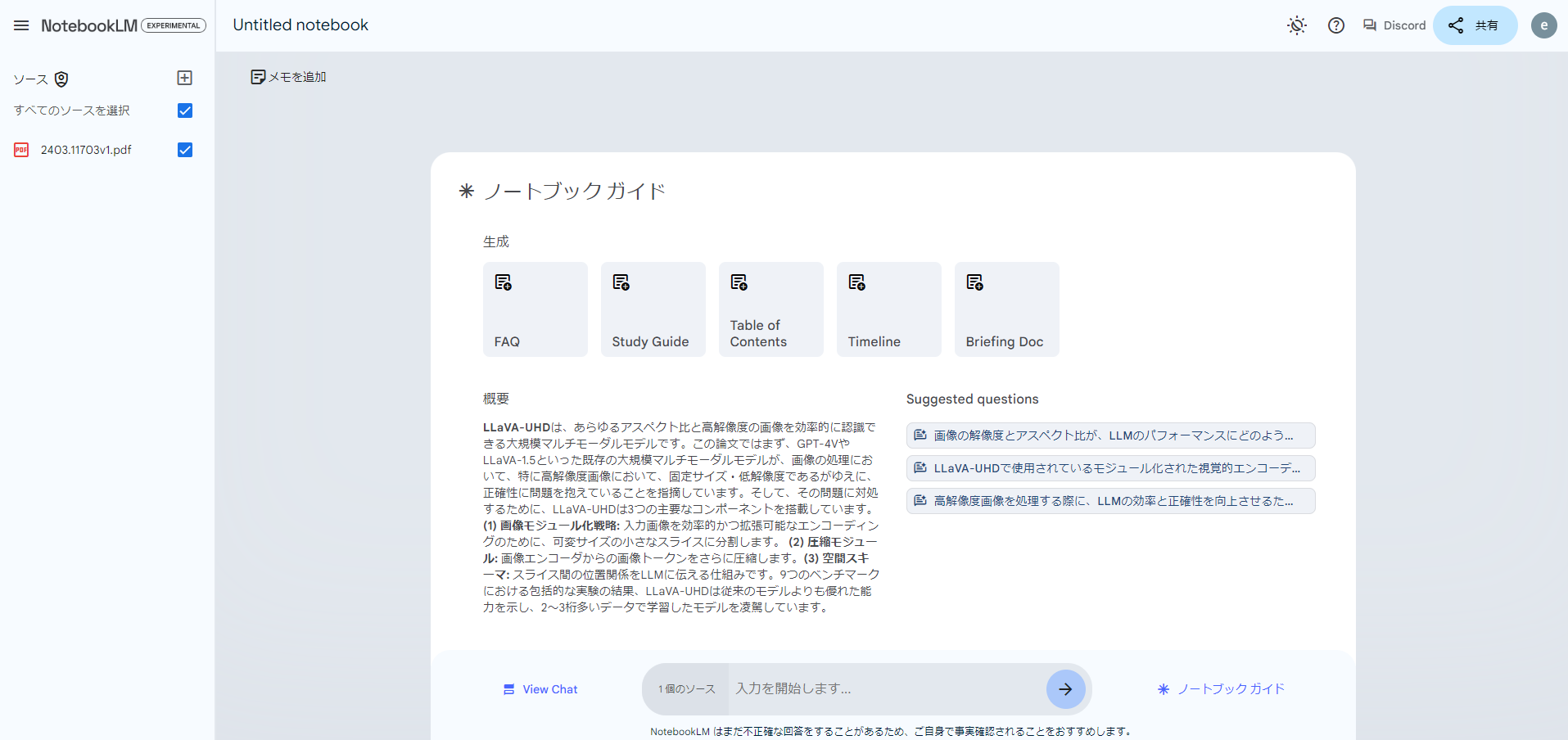

試しに、英語の論文をアップロードしてみます。対象は、「LLaVA-UHD: an LMM Perceiving Any Aspect Ratio and High-Resolution Images」という論文で、Paper with Codeのトレンドにあった論文です。

アップロードするとこんな感じです

資料の概要を説明してくれました。

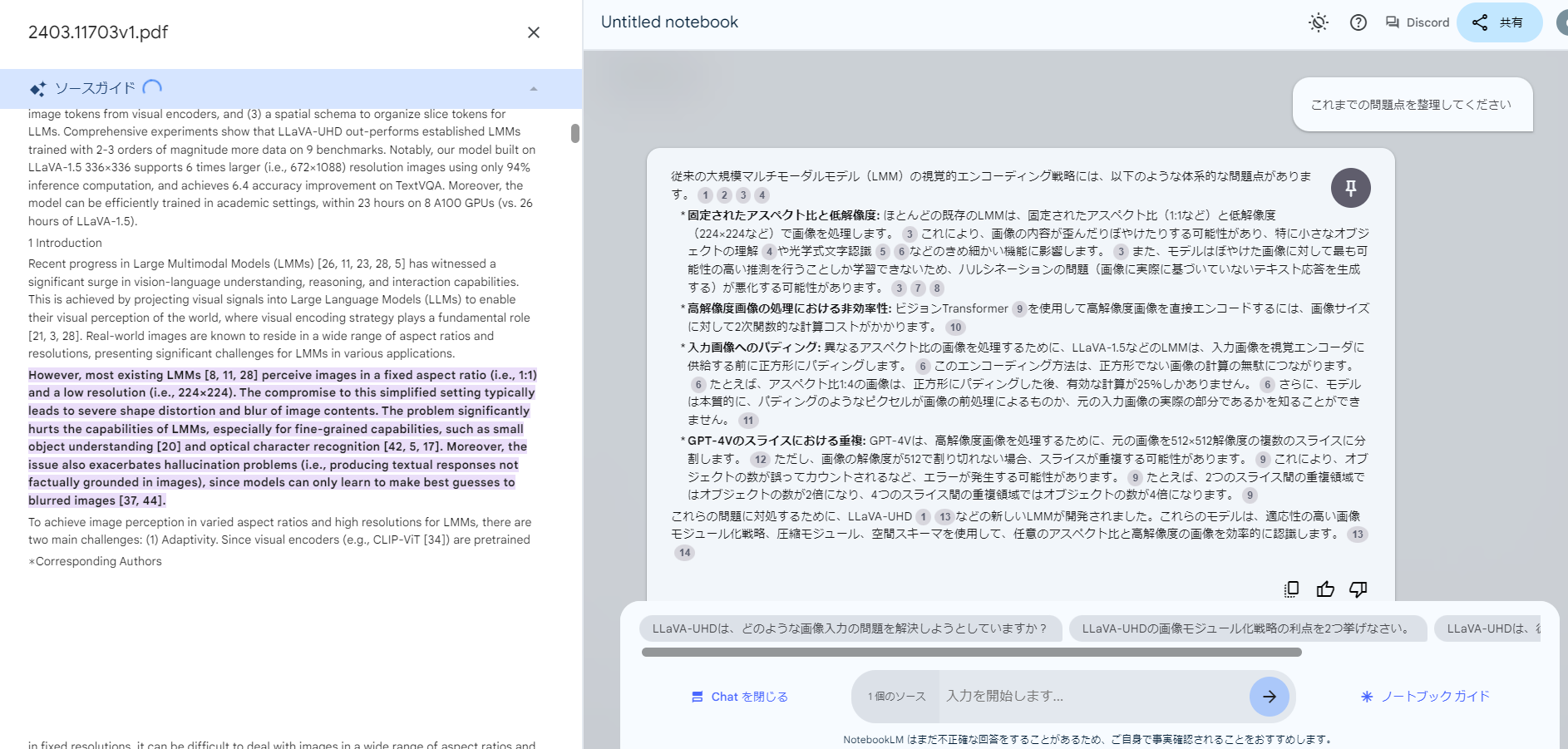

質問すると、こんな感じで回答が返ってきます。

①②③のように引用番号が付いていて、資料の文章中から参考にした場所を教えてくれます。

まぁ、英語を読む気が起きないから、NoteBookLMを使っているので、原文を読む気にはなかなかなりません。

以下、質問と回答についてまとめておきました。

ユーザー: これまでの問題点を整理してください

従来の大規模マルチモーダルモデル(LMM)の視覚的エンコーディング戦略には、以下のような体系的な問題点があります。

* **固定されたアスペクト比と低解像度:** ほとんどの既存のLMMは、固定されたアスペクト比(1:1など)と低解像度(224×224など)で画像を処理します。 これにより、画像の内容が歪んだりぼやけたりする可能性があり、特に小さなオブジェクトの理解や光学式文字認識などのきめ細かい機能に影響します。 また、モデルはぼやけた画像に対して最も可能性の高い推測を行うことしか学習できないため、ハルシネーションの問題(画像に実際に基づいていないテキスト応答を生成する)が悪化する可能性があります。

* **高解像度画像の処理における非効率性:** ビジョンTransformerを使用して高解像度画像を直接エンコードするには、画像サイズに対して2次関数的な計算コストがかかります。

* **入力画像へのパディング:** 異なるアスペクト比の画像を処理するために、LLaVA-1.5などのLMMは、入力画像を視覚エンコーダに供給する前に正方形にパディングします。 このエンコーディング方法は、正方形でない画像の計算の無駄につながります。 たとえば、アスペクト比1:4の画像は、正方形にパディングした後、有効な計算が25%しかありません。 さらに、モデルは本質的に、パディングのようなピクセルが画像の前処理によるものか、元の入力画像の実際の部分であるかを知ることができません。

* **GPT-4Vのスライスにおける重複:** GPT-4Vは、高解像度画像を処理するために、元の画像を512×512解像度の複数のスライスに分割します。 ただし、画像の解像度が512で割り切れない場合、スライスが重複する可能性があります。 これにより、オブジェクトの数が誤ってカウントされるなど、エラーが発生する可能性があります。 たとえば、2つのスライス間の重複領域ではオブジェクトの数が2倍になり、4つのスライス間の重複領域ではオブジェクトの数が4倍になります。

これらの問題に対処するために、LLaVA-UHDなどの新しいLMMが開発されました。これらのモデルは、適応性の高い画像モジュール化戦略、圧縮モジュール、空間スキーマを使用して、任意のアスペクト比と高解像度の画像を効率的に認識します。

ユーザー : LLaVA-UHDは、どのような画像入力の問題を解決しようとしていますか?

LLaVA-UHDは、既存の大規模マルチモーダルモデル(LMM)が抱える、画像入力に関する以下の問題を解決しようとしています。

* **固定されたアスペクト比と低解像度の画像しか認識できない問題**: 多くのLMMは、1:1のアスペクト比で、224×224のような低解像度の画像しか処理できません。この制限により、画像の歪みやぼやけが発生し、小さなオブジェクトの認識や光文字認識(OCR)などの細かいタスクの精度が低下します。また、ぼやけた画像から推測するしかないため、ハルシネーション問題(画像に事実として基づいていないテキスト応答を生成すること)も悪化する可能性があります。

* **高解像度画像の処理効率が悪い問題**: Vision Transformerを使用して高解像度画像を直接エンコードすると、画像サイズに対して計算コストが2次関数的に増加します。また、高解像度画像から生成される大量のビジュアルトークンをLLMが処理する際の計算コストも膨大になります。

* **画像のエンコード方法による問題**: 既存のLMMでは、画像のアスペクト比を固定サイズに合わせるためにパディングを行うことがありますが、これにより計算リソースの無駄が生じ、モデルの能力が低下する可能性があります。また、パディングされた領域と実際の画像部分をモデルが区別できないため、敵対的な攻撃に対して脆弱になる可能性があります。

これらの問題を解決するために、LLaVA-UHDは以下のような特徴を持っています。

* **画像モジュール化戦略**: 任意のアスペクト比と高解像度の画像を効率的にエンコードするために、画像を小さな可変サイズの「スライス」に分割します。この方法により、パディングや形状歪みを引き起こすリサイズなしで、画像を元の解像度のまま処理できます。

* **圧縮モジュール**: ビジュアルエンコーダーからの画像トークンをさらに圧縮し、LLMの処理に必要な計算量を削減します。

* **空間スキーマ**: スライスされた画像トークンを空間的に整理し、LLMに画像内のスライスの位置を伝えます。

これらの特徴により、LLaVA-UHDは、従来のLMMと比較して、高解像度画像の認識精度と処理効率を大幅に向上させています。

ユーザー : LLaVA-UHDの画像モジュール化戦略は、具体的にどのように機能しますか?

LLaVA-UHD の画像モジュール化戦略は、高解像度画像を処理するために、画像をより小さな可変サイズの「スライス」に分割します。この手法により、画像全体を一度にエンコードする従来の手法に比べて、効率と拡張性が向上します。 この戦略の重要な点は、各スライスの形状が、ViT(Vision Transformer)の標準的な事前トレーニング設定から大きく逸脱しないようにすることです。 可変サイズのスライスを使用することで、LLaVA-UHD は、パディングや形状を歪ませるリサイズを行うことなく、さまざまなアスペクト比や解像度の画像に完全に適応できます。

LLaVA-UHD のモジュール化された視覚エンコーディングは、次のような手順で行われます。

* **高解像度画像の分割戦略**: まず、入力画像の解像度(WI、HI)と、ViT の事前トレーニング済み解像度(Wv、Hv)に基づいて、画像を処理するために必要な理想的なスライス数(計算量)を決定します。計算式は次のとおりです。N = ⌈WI×HI / Wv×Hv⌉。

* **理想的なスライス数の因数分解**: 次に、スライス数Nをm列、n行に因数分解します。CN = {(m,n)|m×n = N, m∈N, n∈N}。

* **最適な分割の選択**: 考えられる各分割について、ViTの標準的な事前トレーニング設定からのずれを測定するスコア関数を定義します。 スコアが高いほど、偏差が小さく、その分割が優先されます。

* **境界ケースへの対応**: 理想的なスライス数Nに加えて、N-1、N+1というわずかなスライス数の変更も許容することで、より多くの分割選択肢を組み込んでいます。これにより、特に素数の場合など、Nの因数分解の選択肢が限られている場合に、極端な画像分割を防ぐことができます。

* **任意のアスペクト比でのスライスエンコーディング**: 各スライスは、分割戦略で決定されたアスペクト比でエンコードされます。元の画像は、アスペクト比に従って比例的にサイズ変更され、パッチの数が、ViT の事前トレーニング時の位置埋め込みの数である M に最大限に収まるようにします。

* **事前トレーニング済み位置埋め込みの再形成と補間**: 次に、ViT の事前トレーニング済みの 1 次元位置埋め込みシーケンスを、その事前トレーニング設定に従って 2 次元形式 P∈Rq×q×l に再形成します。ここで、M = q × q で、l は位置埋め込みの次元です。その後、分割戦略によって与えられたスライス解像度に適合するように、P を 2 次元補間して、視覚エンコーディングを行います。

このモジュール化戦略により、各スライスのアスペクト比は [1:2, 2:1] の範囲内に収まり、各スライスの面積は [0.33WIHI, 1.5WIHI] の範囲内に収まることが理論的に保証されています。 言い換えれば、この戦略により、各スライスは ViT の標準的な事前トレーニング解像度(Wv、Hv)に対して、平均的な変更と、最悪の場合でも moderate な変更に抑えられます。

さらに、LLaVA-UHD は、各スライスの視覚的なトークンを圧縮し、LLM への計算負荷を軽減するために、圧縮層を採用しています。 また、画像の分割は画像によって異なるため、LLM に画像スライスの空間的な構成を伝えるために、空間スキーマも使用されます。

いい感じに説明してくれます。理系の修士レベルであれば、回答を理解することも難しくないので、一人輪講などができるようになります。

英語の学術書籍を与えてみる

先程のpdfは16ページのものでした(本文は11ページ)。もっと長い文章だとどうでしょうか?

「Introduction to Evolutionary Computing」という本を与えてみます。この本は294ページの英語書籍です。

https://warin.ca/ressources/books/2015_Book_IntroductionToEvolutionaryComp.pdf

アップロードすると概要が説明されます。長編の資料でも問題なく動作するようですね。

なるほど。資料に基づいて返答しているのは確かなようです。

これがあれば、積んでいた長編英語書籍を解消できるかもしれません。

URLから資料を読み込む

URLから資料を読み込むこともできます。

試しに英語のライセンス条項を解説してもらいます。ライセンスが書かれたページを用意します。

今回は、stable-audio-open-1.0のLICENSEファイルのURLを与えてみます。

便利ですね!私が知りたいのは多くの場合、商用利用していいかどうかです。だから、それに的確に答えてくれるのはありがたいです。

※NotebookLMのチャット欄にも書いてありますが、不正確な回答をすることがあるので、事実確認はしたほうが良いです。

課題点

使ってみると、いくつかの課題点も見受けられました。

- 画像データ・ファイルを読み込めない

- pdfやwebページに画像データがあったとしても、それを読み込むことはできません。画像が意味する重要な情報を落としている可能性があります。

- 創造性は乏しい

- 資料を元に「〇〇を作って」や「■■を考えて」などの質問は、まともに答えてくれません。アイディア帳というよりは、資料のまとめノートとして使うのが良いと思います。

- 書いてないことには絶対に答えない

- 一般知識であっても、書いてないことには絶対に答えてくれません。「富士山の場所」などの質問にも回答は返ってきませんでした。これは一長一短となる可能性があります。

全体としてはよくできていると思いました。特に、「組織の資料をまとめて、それに質問できる」という使い方なら、不都合は生じないと思います。また、英語資料を読む手助けをしてくれるツールとしては、かなり優秀だと思いました。

今後、画像データにも対応してくれることを願っています。